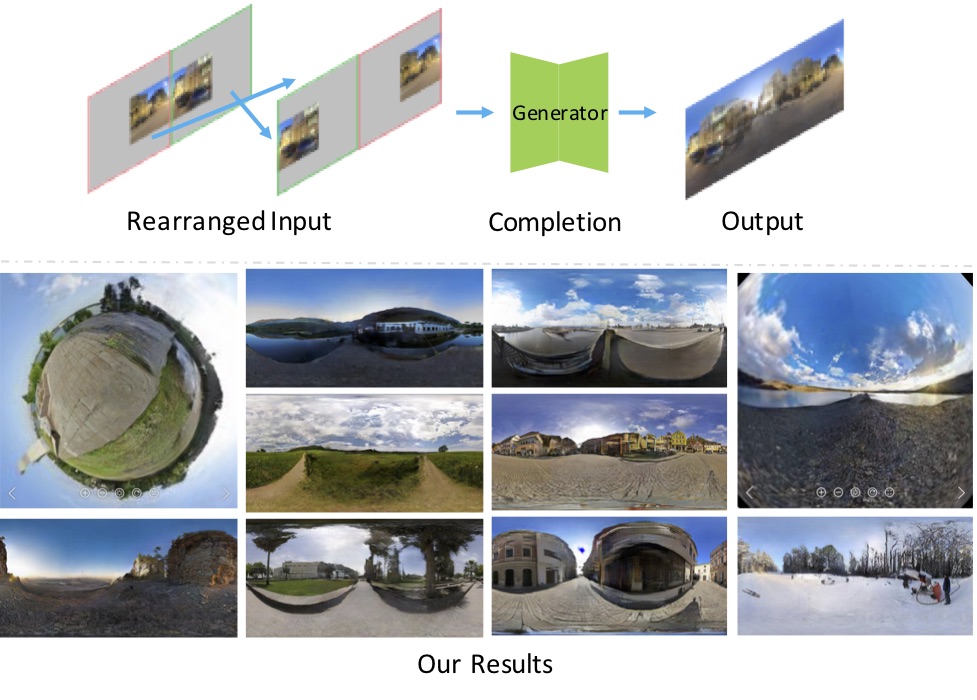

効率的な3DCG背景制作のための360度画像の周辺補完

※Accepted to CVPR2022 : Arxiv , OSS

360度画像は,3DCG制作において効率的にシーンを制作するために,全周囲を表現する背景画像として利用されます.本研究では,1枚の通常画角の画像を入力として,その周囲を補完することで,360度画像を生成する問題に取り組みます.Transformerを用いた提案手法は,先行手法の結果と比べて,より高解像度で自然な見た目の出力画像を得られます.さらに,一つの入力に対して,多様な結果画像を出力することが可能なため,利用者は多くの選択肢を得られます.このようにして,本研究は利用者の効率的でオリジナリティのある3DCG制作の支援を目指しています.

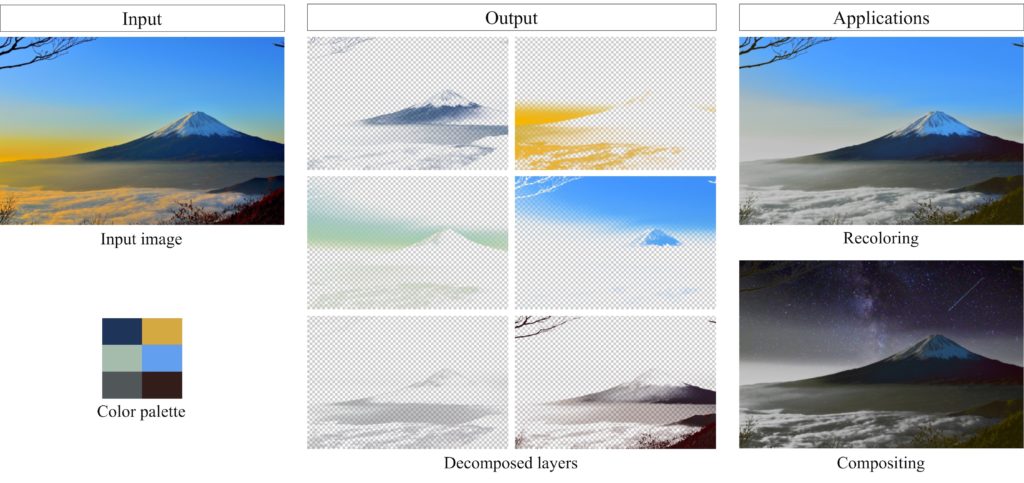

Fast Soft Color Segmentation

※Accepted to CVPR2020 : Arxiv , OSS

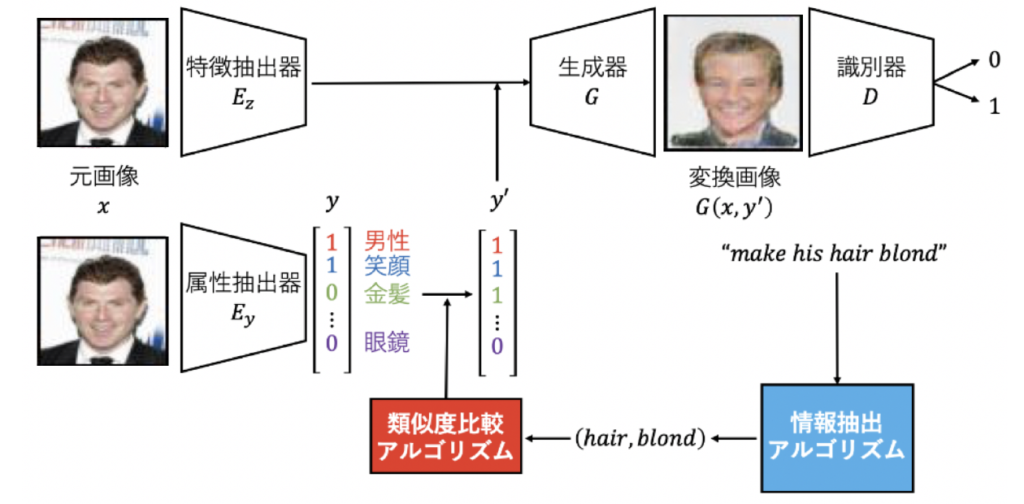

自然言語指示文による物体画像の属性変換

画像編集ソフトウェアの出現により,画像編集は活発に行われるようになった.これによってわずかな形状や色の調整などの単純な画像編集は容易となったが,人間の顔などの複雑な物体の画像を自然に編集するには依然として高度な技術が必要となる.本研究では,人間の顔画像に着目し,その属性を,英語の指示文のみを条件として変換することを目的とする.自然言語の指示文を条件とした顔画像の属性変化に基づく画像変換という問題設定を評価する評価指標を新たに設け,提案手法の評価を行う.

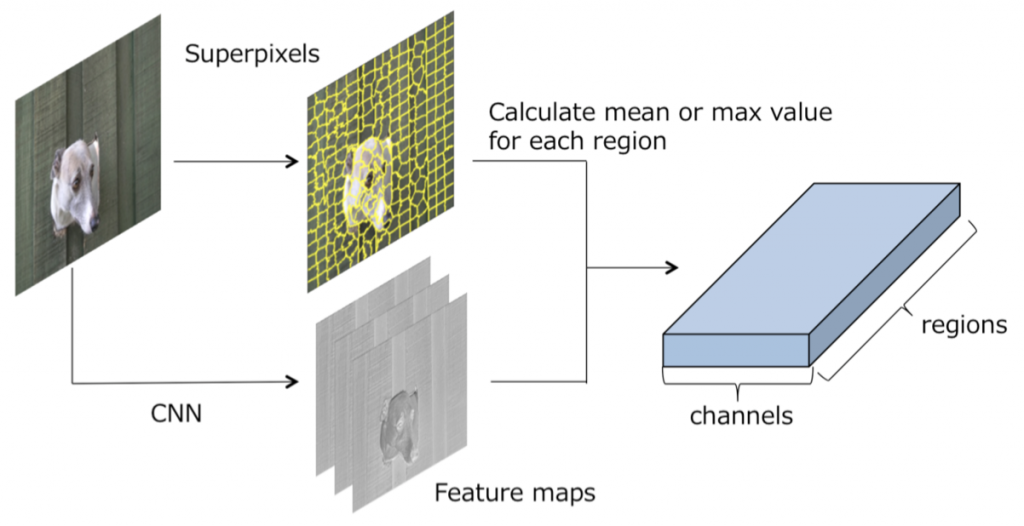

Segmentation のためのスーパーピクセル上でのGraph Convolutional Neural Networks

CNNを用いた画像領域分割の欠点として,プーリング層によるダウンサンプリングが原因で空間的な情報が欠落してしまい物体の輪郭付近での領域分割精度が低下する点があった.そこで,プーリングによる情報の欠落を防ぐ別のアプローチとして,スーパーピクセル上でのグラフ畳み込み(Graph Convolution)を提案した.また,グラフ畳み込みの拡張として,より効果的に受容野を広げるDilated Graph Convolutionを提案した. HKU-ISデータセットを用いた領域分割の課題において,提案手法が同一構成の従来のCNNを上回る性能を達成した.

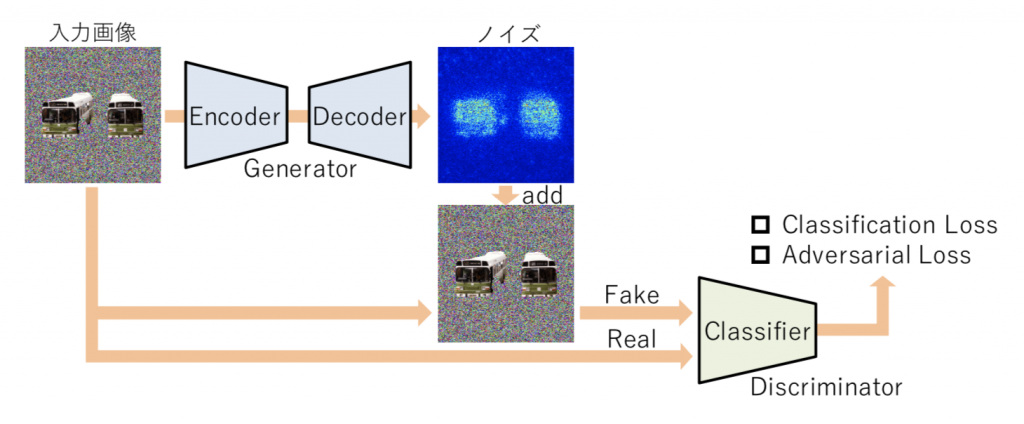

CNN分類器を用いた画像識別における顕著性マップ生成

一般的に画像をCNN に入力し特定の出力が得られた場合に,なぜそのような出力が得られたかを説明することは難しい.本研究では,Generative Adversarial Networksの枠組みを応用した顕著性マップの生成手法を提案する.このシステムでは2つのニューラルネットワークを競わせながら学習する.1つ目のネットワークは,画像識別を行うように学習する.2つ目のネットワークは,ある画像が1つ目のネットワークに入力されてうまく画像識別ができる場合に,この画像には似ているが1つ目のネットワークに入力した場合に間違った結果を出力するような画像を生成するように学習する.2つ目のネットワークがこのような画像を効率的に生成するためには,1つ目のネットワークの画像識別において大切な画像領域を大きく変化させた画像を生成すれば良い.このような学習を行うことで,画像識別において重要な画像領域が明示的に出力可能となるため,これを顕著性マップとして捉えることができる.

GANによるカラー調整と画像補完の同時実行

本研究では,カラー調整と画像補完で自然な貼り付け合成を行う問題を解決するために,コンテキストを考慮したカラー調整を行いつつ画像補完を行う手法を提案する.挿入するオブジェクト画像を明示的に補完領域に出現させるようにするため,コンテキストを考慮した補完にCNNとGenerative Adversarial Network (GAN)を利用し,背景画像全体からコンテキストに関する特徴を抽出する.さらにそのコンテキストの特徴を,画像補完のためだけでなく,カラー調整にも利用することで,コンテキストを考慮したカラー調整を行う.このようにして,カラー調整と画像補完の課題を同時に解決するネットワークを実現する.

cGANによる360度画像の補完

本研究では,360度画像の一部の領域を入力として,残りの領域をGANsで補完するという新しい問題設定に取り組んだ.正距円筒図法で表現される360度画像に固有の歪みを捉えることに有効な構造として,直列かつ並列に並んだDilated Convolution層を含むGeneratorを提案する.さらに,データ拡張や問題の簡単化のために入力画像に対して行う操作を提案する.これらの提案手法によってGeneratorが自然な360度画像を生成することができる.この研究は,GANsによって360度空間の見えない領域を予測するという難問への初めの一歩となる.

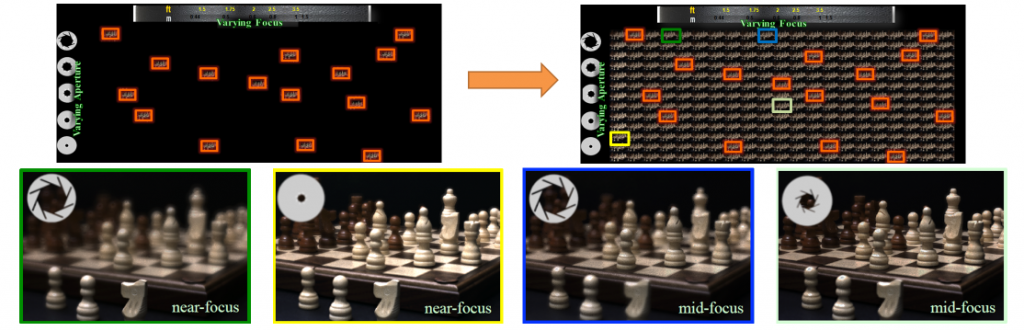

圧縮センシングを用いたEpsilon Photography再構成による撮影後の画像制御

従来、撮影者はカメラにおける数多くのパラメータを撮影時に選択しなければならない.ライトフィールド撮影は,フォーカス位置と撮影視点について撮影後の画像制御を可能にしたが、解像度が低く、専用ハードウェアが必要であり,フォーカス位置や絞りの大きさの完全にフレキシブルな復元はできない.本研究は,従来カメラを用いて、フォーカス位置や絞りの大きさ,露光時間,ISOなどのパラメータを変えて連射撮影された10数枚の撮影画像から,あらゆるパラメータで撮影された画像を復元する技術に関するものである.たとえば,あらかじめ設定されたパラメータによる連写画像を入力とし,高ダイナミックレンジなFocus-Apertureスタックを完全に再構成する.