最近の研究成果

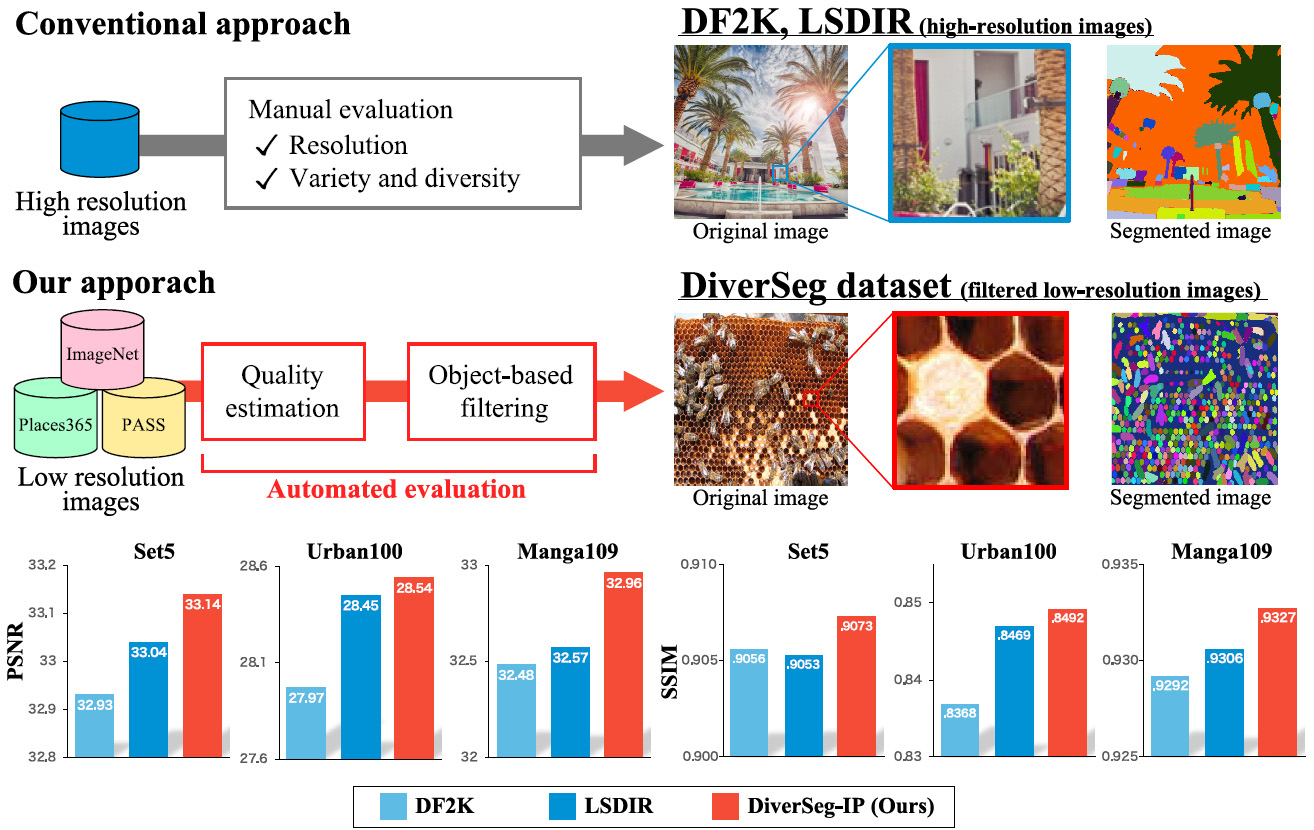

Rethinking Image Super-Resolution from Training Data Perspectives

従来,画像超解像分野において,高解像度で圧縮ノイズが少ない画像が超解像学習を成功させる既成概念となっていた.本研究では,Blockiness分布計測による画質評価, 画像セグメント数計測による被写体の多様性,およびこれらがSR学習成功の本質であることを実証する.提案するDiverSegデータセットは,低解像度なWeb収集画像で構成されているにも関わらず,既存の超解像データセットよりも高い性能を示した.

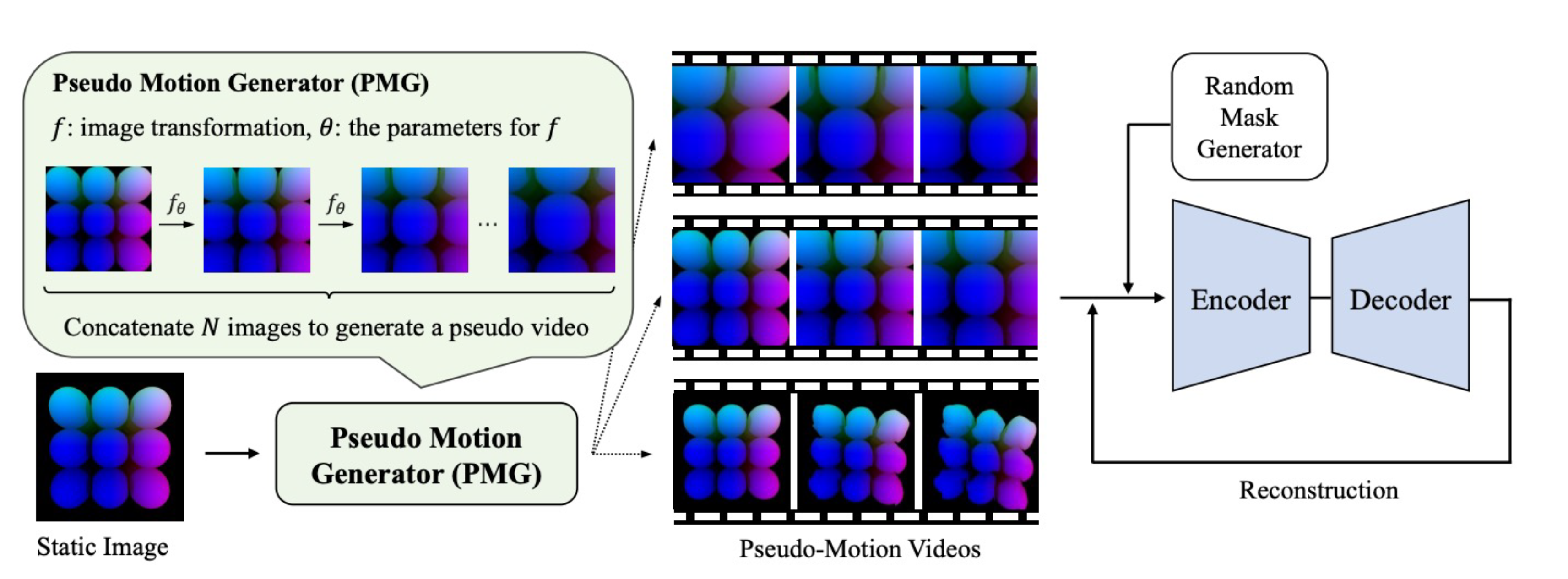

Data Collection-free Masked Video Modeling

video transformerの事前学習には一般に大量のデータが必要であるが、大量の動画を収集・使用することは、コストが高いだけでなく、プライバシー、ライセンス、バイアスなどの問題が伴う。人工データを使用することは、これらの問題を解決する有望な方法の一つであるが、人工データのみで事前学習を行うことには依然として難しい課題である。本論文では、容易に入手可能で低コストな静止画像を活用して、動画認識モデルのための自己教師あり学習のフレームワークを提案する。提案法では、静止画に対して画像変換を再帰的に適用することで、擬似的な動きを持つ動画を生成する Pseudo-Motion Generator(PMG)モジュールを用いる。PMGによって生成された動画は、その後Masked Video Modelingの学習に活用される。本アプローチは、自然画像だけでなく人工画像にも適用可能であり、動画認識モデルの事前学習における、データ収集コストや実データに関するその他の懸念を解消することが可能である。行動認識タスクにおける実験を通じて、このフレームワークが擬似的な動きを持つ動画を通じて、時空間特徴の効果的な学習を可能にすることを示した。提案手法は、静止画像を使用する既存の手法を大幅に上回り、実動画と人工動画の両方を使用する手法の一部を凌駕することを確認した。

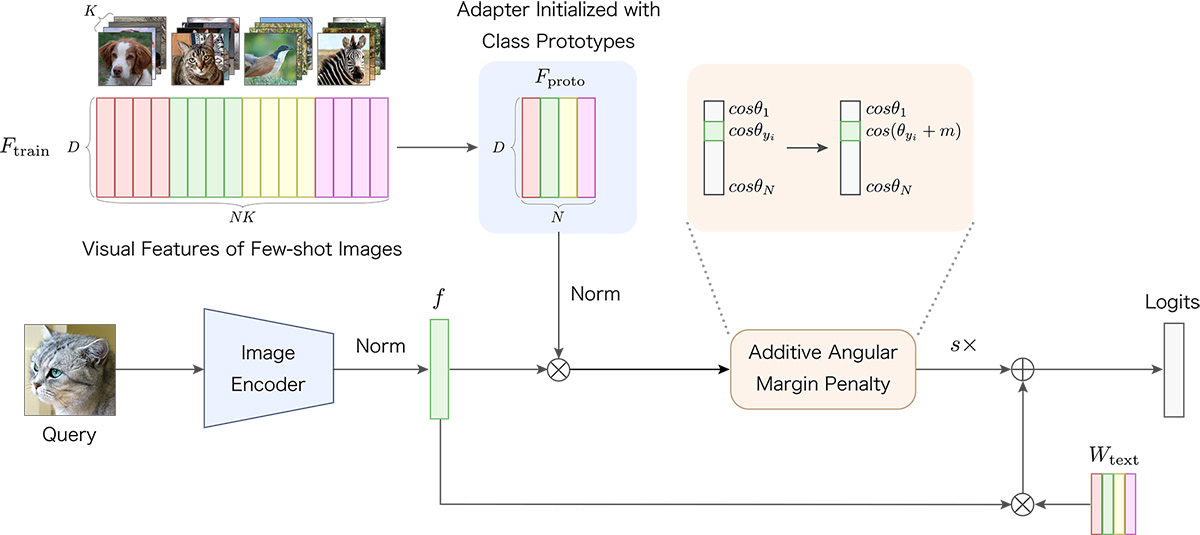

Proto-Adapter: Efficient Training-Free CLIP-Adapter for Few-Shot Image Classification

大量のデータを取得することが困難な応用先において、少数データ学習による画像認識が必要とされる。大規模なvision-languageモデルであるCLIPは、任意のクラスの画像をゼロショットで認識することができる一方で、下流タスクに対する性能には改善の余地が存在する。我々は、少数の学習データを用いてCLIPを下流タスクへ適応させる新たな手法であるProto-Adapterを提案する。本手法はクラス毎のプロトタイプ表現を用いて軽量なアダプターを構築することで、最小限の追加コストで下流タスクの性能を大幅に改善することが可能である。11種類の画像認識ベンチマークを用いた実験により、提案手法の有効性を確認した。

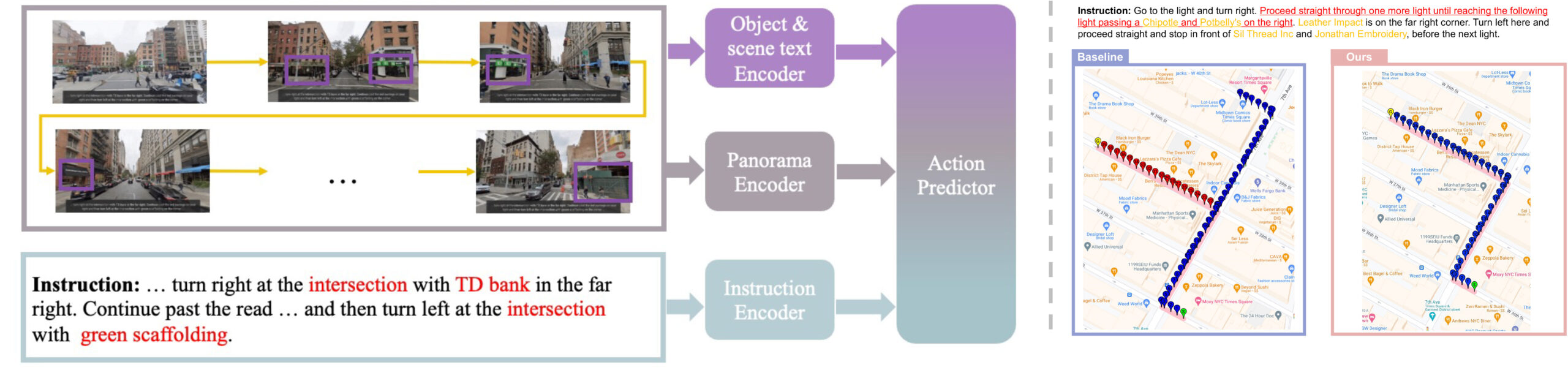

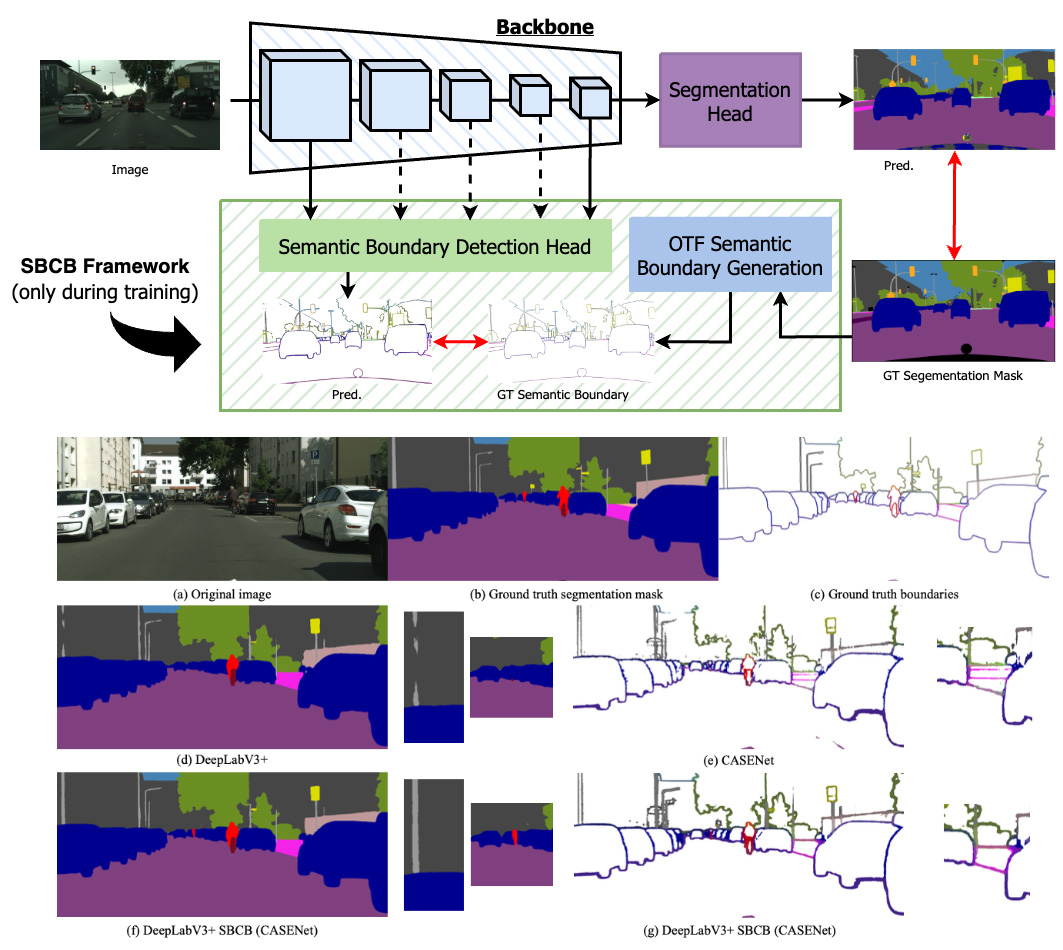

Guided by the Way: The Role of On-the-route Objects and Scene Text in Enhancing Outdoor Navigation

https://2024.ieee-icra.org

In outdoor environments, Vision-and-Language Navigation (VLN) requires an agent to rely on multi-modal cues from real-world urban environments and natural language instructions. While existing outdoor VLN models predict actions using a combination of panorama and instruction features, this approach ignores objects in the environment and learns data bias to fail navigation. According to our preliminary findings, most instances of navigation failure in previous models were due to turning or stopping at the wrong place. In contrast, humans intuitively frequently use identifiable objects or store names as reference landmarks, ensuring accurate turns and stops, especially in unfamiliar places. To address this insight gap, we propose an Object-Attention VLN (OAVLN) model that helps the agent focus on relevant objects during training and understand the environment better. Our model outperforms previous methods in all evaluation metrics under both seen and unseen scenarios on two existing benchmark datasets, Touchdown and map2seq.

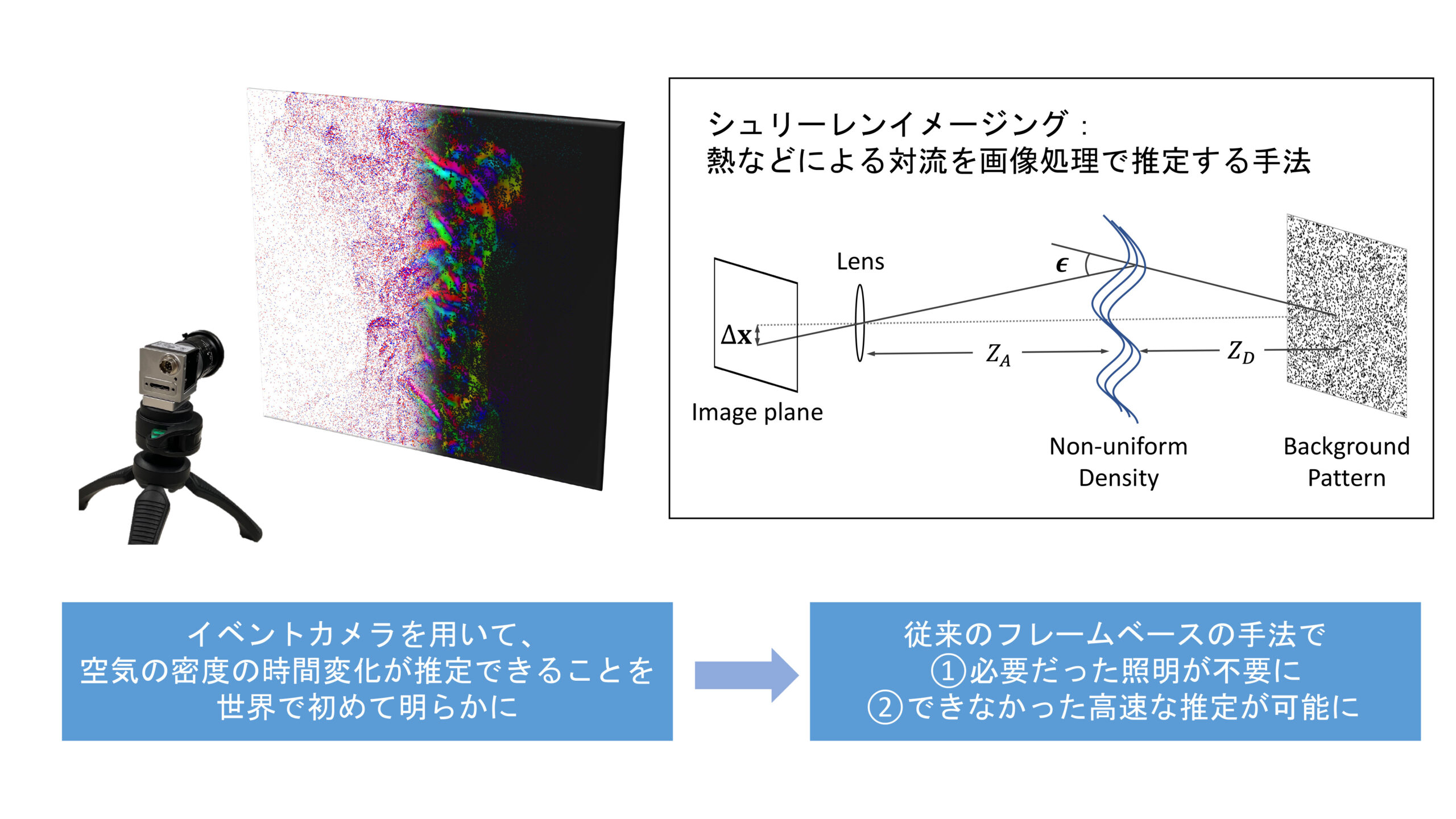

イベントカメラを用いたシュリーレンイメージング技術による空気の対流の非侵襲推定

https://ieeexplore.ieee.org/document/10301562

シュリーレンイメージングとは、空気のような透明な媒質の密度変化をカメラで可視化する手法である。変化だけを記録するイベントカメラは、従来のフレームカメラと比べて、高速・高ダイナミックレンジの特徴を持つ。このような特性を活かして、イベントカメラを用いたシュリーレンイメージング技術を世界で初めて開発した。空気の熱対流などにおける密度の時間変化を推定できることを理論的・実験的に実証した。さらに、イベントカメラの特性によって、従来のフレームベースのイメージングに必要だった照明器具を不要にし、スローモーションでの解析ができることも示した。

Video:https://www.youtube.com/watch?v=Ev52n8KgxIU

Code:https://github.com/tub-rip/event_based_bos

Paper:https://ieeexplore.ieee.org/document/10301562

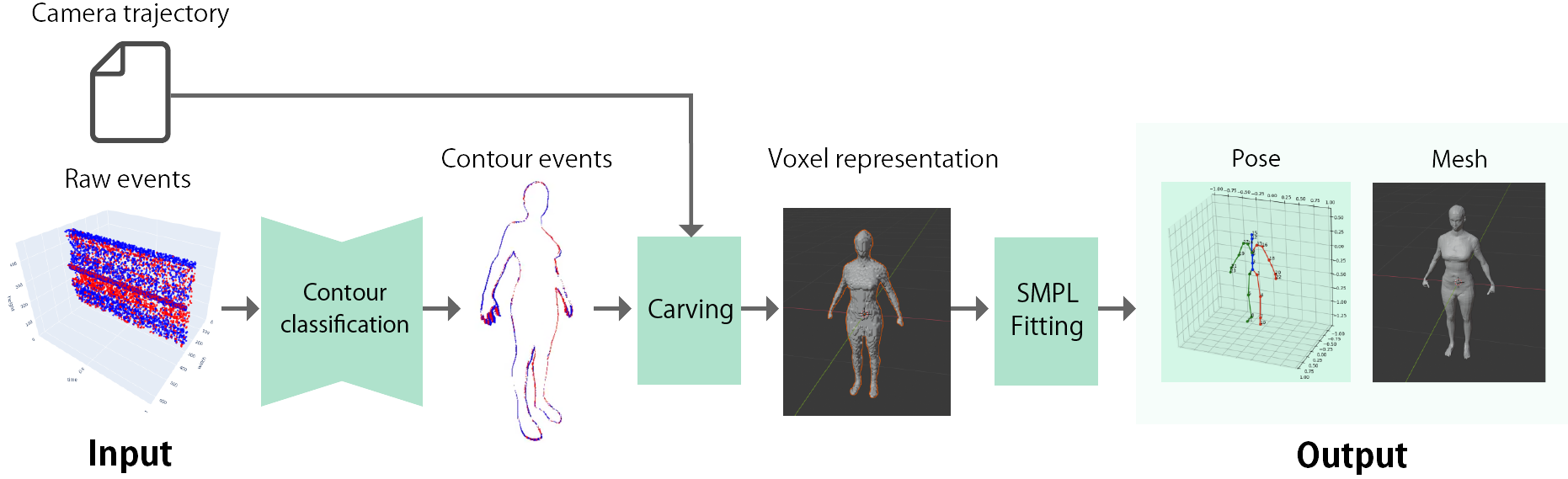

イベントカメラを用いた三次元人体スキャン

Project page: https://florpeng.github.io/event-based-human-scan/

Arxiv: https://arxiv.org/abs/2404.08504

従来の三次元姿勢推定・人体メッシュ復元手法は,カメラ自体の時間分解能やダイナミックレンジの限界によりシーンが制約される.そこでイベントカメラを用い,フレーム画像を利用せずにイベントのみから人体の3Dスキャンを行う手法を提案した.

提案手法はフレームベースの従来手法より高い精度での復元を実現したほか,ブラーの生じるような激しいカメラの動きに対する有効性も示した.

小売商品棚を対象にした画像認識のための大規模データセット構築

小売商品棚を対象にした画像認識のための大規模データセットを作成した. 小売商品棚は, 1枚の画像に大量の商品が同時に存在するという特性上, アノテーションコストが極めて高い. そこで我々は、3DCGを利用してフォトリアルな小売商品棚の画像を作成し, 同時にオブジェクトの3D座標データをもとにアノテーションを自動で付与することで, 200クラス、100,000枚の大規模なデータセットを作成した.

データセットはリンク先のページからダウンロード可能(利用は研究目的に限る).

CG Retail Shelves Dataset

– A Massive-Scale, Photorealistic, Rich Annotated CG Dataset for Retail Image Processing –

https://yukiitoh0519.github.io/CG-Retail-Shelves-Dataset/

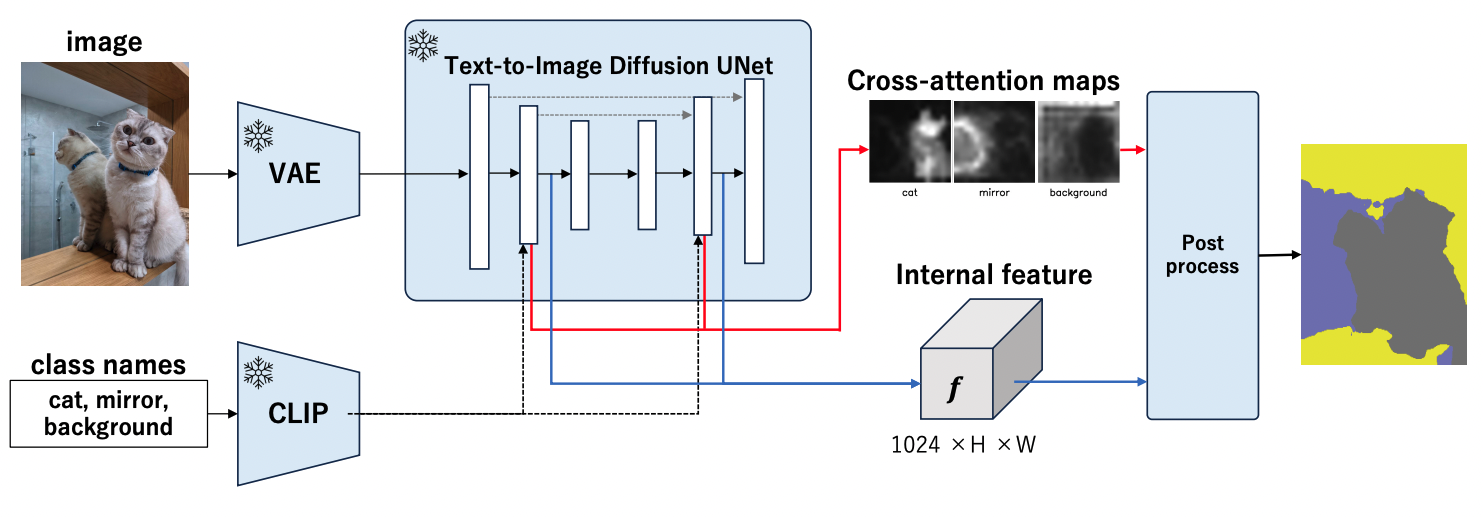

MaskDiffusion: Exploiting Pre-trained Diffusion Models for Semantic Segmentation

MaskDiffusionは、学習済みの拡散モデルを活用した、追加の訓練やアノテーションを必要とせずにオープンボキャブラリーのセマンティックセグメンテーション手法である。我々は、MaskDiffusionが細かい固有名詞ベースのカテゴリーを含むオープンボキャブラリーを扱う際に優れた性能を発揮することを実証し、セグメンテーションの応用範囲を拡大する。MaskDiffusionは、Potsdamデータセット(+10.5mIoU)やCOCO-Stuff(+14.8mIoU)など、他の同等の教師なしセグメンテーション手法と比較して定性的、定量的に大きな改善を示している。

Arxiv: https://arxiv.org/abs/2403.11194

Code : https://github.com/Valkyrja3607/MaskDiffusion

TAG: Guidance-free Open-Vocabulary Semantic Segmentation

我々は、トレーニング、アノテーション、ガイダンスを必要としないオープンボキャブラリーセマンティックセグメンテーションを実現する新しいアプローチ、TAGを提案する。TAGは、CLIPやDINOのような事前に訓練されたモデルを利用し、追加の訓練や密なアノテーションなしに、画像を意味のあるカテゴリにセグメンテーションする。外部データベースからクラスラベルを取得し、新しいシナリオに適応する柔軟性を提供する。TAGは、PascalVOC、PascalContext、ADE20Kにおいて、クラス名を指定しないオープンボキャブラリのセグメンテーションで最先端の結果を達成している。

Arxiv: https://arxiv.org/abs/2403.11197

Code : https://github.com/Valkyrja3607/TAG

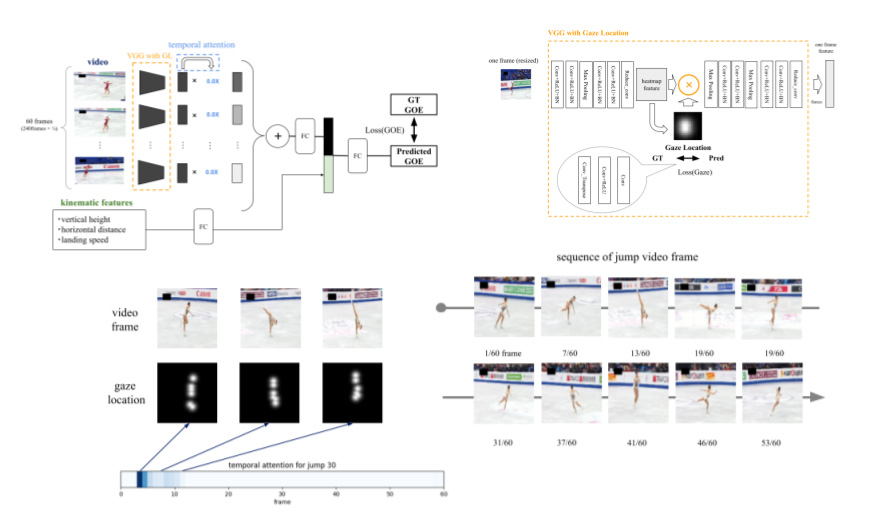

専門家の視線を活用したフィギュアスケートジャンプの質の評価

演技動画とトラッキングシステムから得られる運動学的特徴量を用いてジャンプの出来栄え点を予測する手法を提案した。提案手法では、時間情報の重み付けに加えて、演技動画からジャンプの出来栄えに影響のある特徴量を抽出するために人間の審判と選手の視線配置による空間方向の情報の重み付けを行うことで、ベースラインモデルからの精度向上を達成した。

専門家の視線を活用したフィギュアスケートジャンプの質の評価

演技動画とトラッキングシステムから得られる運動学的特徴量を用いてジャンプの出来栄え点を予測する手法を提案した。提案手法では、時間情報の重み付けに加えて、演技動画からジャンプの出来栄えに影響のある特徴量を抽出するために人間の審判と選手の視線配置による空間方向の情報の重み付けを行うことで、ベースラインモデルからの精度向上を達成した。

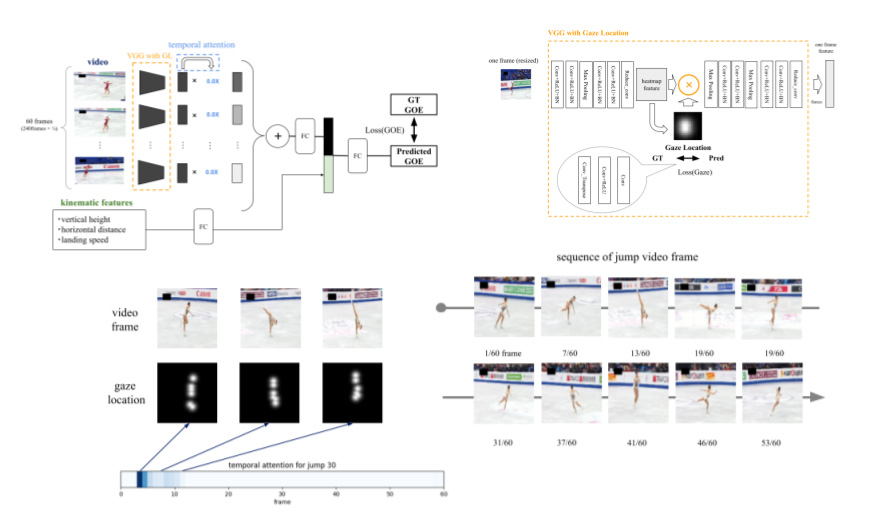

Boosting Semantic Segmentation by Conditioning the Backbone with Semantic Boundaries

Semantic Boundary Conditioned Backbone (SBCB) フレームワークは,多様なセグメンテーション・アーキテクチャとの互換性を維持しながら,特にマスク境界でのセマンティック・セグメンテーションのパフォーマンスを向上させる効果的な学習方法です.このフレームワークは,セグメンテーション・アーキテクチャのバックボーンから得られるマルチスケールの特徴をセマンティック境界検出(SBD)のマルチタスク学習を行い,より境界を理解した特徴を得られます.このアプローチにより,Cityscapes データセットで平均 1.2% の IoU 向上と 2.6% のboundary F スコアの向上が達成でき,セグメンテーションの精度が向上しました。 SBCB フレームワークは,ビジョン・トランスフォーマー・モデルを含むさまざまなバックボーンにうまく適応し,モデルに複雑さを導入することなくセマンティック・セグメンテーションを進歩させる可能性を示しています。

Boosting Outdoor Vision-and-Language Navigation with On-the-route Objects

Vision-and-Language Navigation(VLN)タスクは,ロボットが自然言語の指示を使用して実世界の環境をナビゲートすることを目指している.近年、多くのVLNモデルが提案されてきたが,これらは指示とパノラマ特徴を結合して行動のシーケンスを予測し,特定のセマンティクスや物体認識をしばしば見落としている.予備実験により,既存のモデルが物体トークンに十分な注意を払っていないことが明らかとなった.この傾向は,人間が馴染みのない地域をナビゲートする際にランドマークに頼る様子とは対照的である.そこで,本研究はナビゲーション指示内の物体に焦点を当てるように設計された,エージェントの環境理解を向上させるObject-Attention VLN (OAVLN) モデルを提案する.複数のデータセットでの実験結果から,OAVLNの優越性が示され,オブジェクトを主要なナビゲーションランドマークとして活用し,エージェントを正確に制御する能力が確認された.

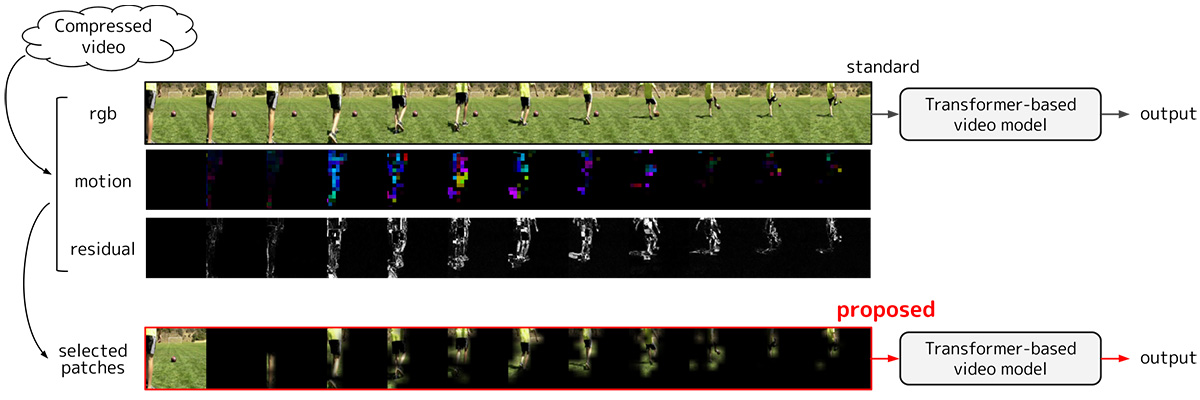

重要パッチ選択に基づく効率的な動画認識

動画は画像と比較して非常に処理コストが高い一方,各フレーム画像は似通っており冗長性が高い.本研究では時間的な動きや変化が小さいパッチを冗長と判断し,入力から除外することで処理コストを削減する動画認識手法を提案した.時間的な動きや変化には圧縮動画を復号する過程で副次的に得られる情報を用いるため,追加で必要な処理コストはパッチを除外することによって削減される処理コストと比較して僅かである.提案手法をTransformerベースの動画認識モデルに適用することで,行動認識において 1 ポイント以下の精度低下で 70 % 以上の処理コスト削減を達成した.

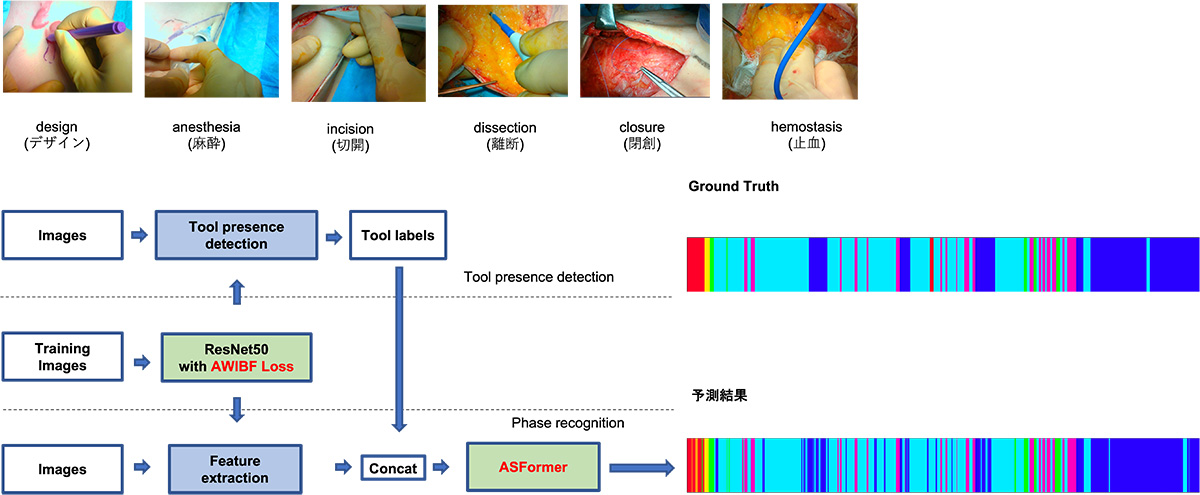

術具情報を考慮した形成外科手術における自動工程分類

本研究では, 形成外科手術動画の手術工程を自動分類するモデルを提案した. 手術動画の中で多く研究されている内視鏡手術に比べ, 形成外科手術動画は手術の種類や体の部位が多様であるため, より汎用的なモデルの構築が必要であった. このような形成外科手術に対して工程分類を行うために, 手術シーンを理解するために重要な術具の情報を加えてに学習させることで高精度を達成した. また, 既存の研究では内視鏡手術でのみ行われていた手術シーンの理解を, 他の外科手術に対しても拡張できることを示した.

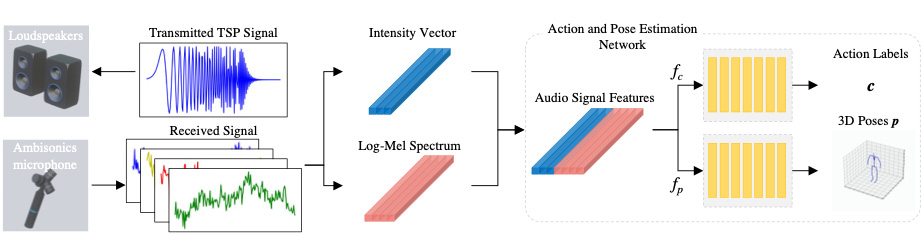

音響情報を用いた人物姿勢推定

音響情報を使用した3次元姿勢推定のための新規フレームワークを提案した.

提案手法は主に

①TSP信号を用いたセンシング

②音響特徴量(Log Mel Spectrum, Intensity Vector)の作成

③1次元CNNを使用した関節座標回帰ネットワーク

の3つのパートから構成されている。音響信号が人の身体で反射した際の振幅の変化や到来方向を捉えることで関節点の3次元座標を高精度で取得することが可能になった.

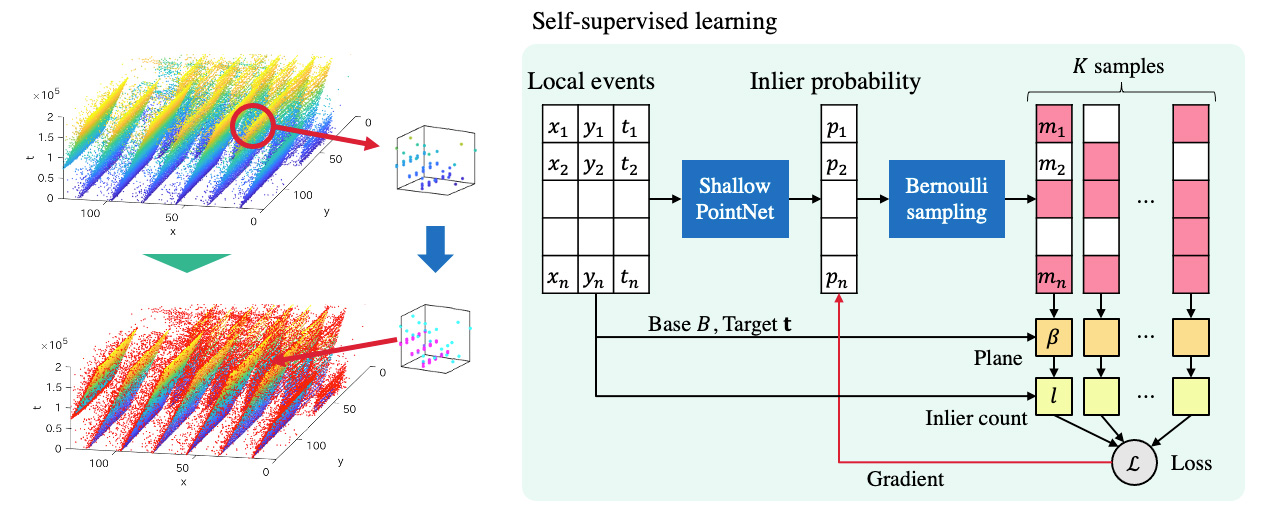

イベントベースオプティカルフロー推定のための自己教師あり学習によるノイズ除去

イベントカメラは画素ごとの輝度変化を非同期かつ高い時間分解能で出力する.

時空間のイベントを局所的に線形だと仮定し,平面にフィッティングすることでnormal flowを推定することができる.

しかし,イベントにはノイズが多く含まれ,外れ値によってフィッティングが悪化するという問題がある.

これに対し,3次元構造を捉えるニューラルネットワークでノイズかどうかを判定する仕組みを導入し,サンプリングをしながら自己教師あり学習を行う手法を提案した.

ルールベースのイベントの選択に対して,推定フローの精度が向上した.

イベントカメラによるオプティカルフローとエゴモーション推定

イベントデータは従来の画像データと性質が大きく異なり、特に非同期的で時空間的な特性を持ちます。したがって、例えば近年の画像ベースのディープラーニングをそのまま適用することが必ずしも良いとは限りません。我々の研究では、この時空間的特性を詳細に分析し、さまざまなデータセットやシーンで高精度を達成するエゴモーション推定やオプティカルフロー推定手法を開発しています。特にオプティカルフロー推定では、コントラスト最大化法を拡張する形で、最適化ベースの手法で他の機械学習手法を上回る性能を達成しました。

効率的な3DCG背景制作のための360度画像の周辺補完

360度画像は,3DCG制作において効率的にシーンを制作するために,全周囲を表現する背景画像として利用されます.本研究では,1枚の通常画角の画像を入力として,その周囲を補完することで,360度画像を生成する問題に取り組みます.Transformerを用いた提案手法は,先行手法の結果と比べて,より高解像度で自然な見た目の出力画像を得られます.さらに,一つの入力に対して,多様な結果画像を出力することが可能なため,利用者は多くの選択肢を得られます.このようにして,本研究は利用者の効率的でオリジナリティのある3DCG制作の支援を目指しています.

完全合成画像での学習による文書画像の影除去

文書画像に映り込んだ影の除去は,デジタル化された文書の質向上に重要なアプリケーションである.近年の研究では多くの深層学習ベースの影除去手法が提案されており,これらは影がある画像,影のない画像の集合に対して学習する.これらの一般的な教師あり学習手法では,ペアとなる文書画像の大規模なセットが必要であるが,データセットを作成するためには膨大なコストがかかる.そこで本研究では3DCGレンダラを用いて,実際の文書のキャプチャを必要とせず,大規模かつ多様なデータセットを作成する.実験では,提案したデータセットのみで学習したディープニューラルネットワークが実データに対して良好な性能を発揮し,また,事前学習に用いることで性能に向上があることを示した.

動的シーングラフ生成における物体と関係性の同時検出

動的シーングラフとは,動画における各シーンにおいて物体と物体間の関係性をグラフ構造で詳解することで動画内の包括的な認識を実現する枠組みである.従来は,検出した物体を元に関係性を検出する2段階処理の手法が一般的であったが,このような手法では関係性検出器が物体検出器に依存しており,推論の処理速度がボトルネックとして懸念される.本研究では,物体と関係性を並行して同時に検出することで,物体検出器と関係性検出器の相互学習を実現しつつ,処理速度を向上させる.

Non-Deep Active Learning for Deep Neural Networks

Active Learningとは,教師データを作る際にラベル付けされるべき最も代表的なサンプルをサンプリングすることで,ラベル効率の高いアルゴリズムを設計することである.本研究ではタスクモデルの出力結果から,最も情報量の多いラベル付けされていないサンプルを導出するモデルを提案する.タスクは分類問題,マルチラベル分類とセマンティックセグメンテーション問題の三つを扱う.本モデルは不確実性指標生成器とタスクモデルで構成されている.ラベル付きサンプルでタスクモデルを学習させた後,ラベル無しサンプルをそのタスクモデルに予測させる.その予測結果から不確実性指標生成器がラベル無しサンプルごとの不確実性指標を出力.不確実性指標の高いサンプルを情報量が多いとみなし,サンプルの選択を行う.複数のデータセットを用いた実験の結果,本モデルは従来のActive Learning手法よりも高い精度を得ることができ,実行時間を最大約10分の1に短縮することに成功した.

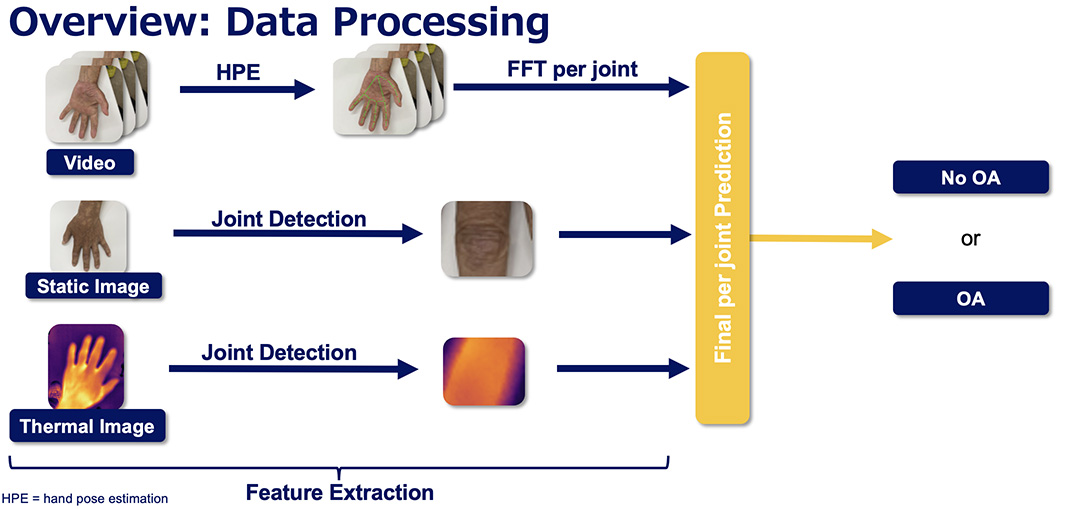

マルチモーダルな手指データによる変形性関節症の検出

世界中で高齢化が進む中、高齢化に伴って発現リスクの高まる関節疾患である変形性手関節症(OA)に罹患する人が着実に増えている.。現状のOA診断は訓練された医師によるエコー診断やX線診断で行われており、患者の負担軽減や診断の効率化を可能にする技術が必要になっている。本研究では、慶應大学病院で新たに集めた200人以上の患者のビデオ、RGB 画像、サーマル画像の3つのモーダルによって構成されるデータを用いて、手指の関節点単位で OAを自動的に検出するパイプラインを提案した。手指のOAを関節単位で診断する研究は本研究が初である。

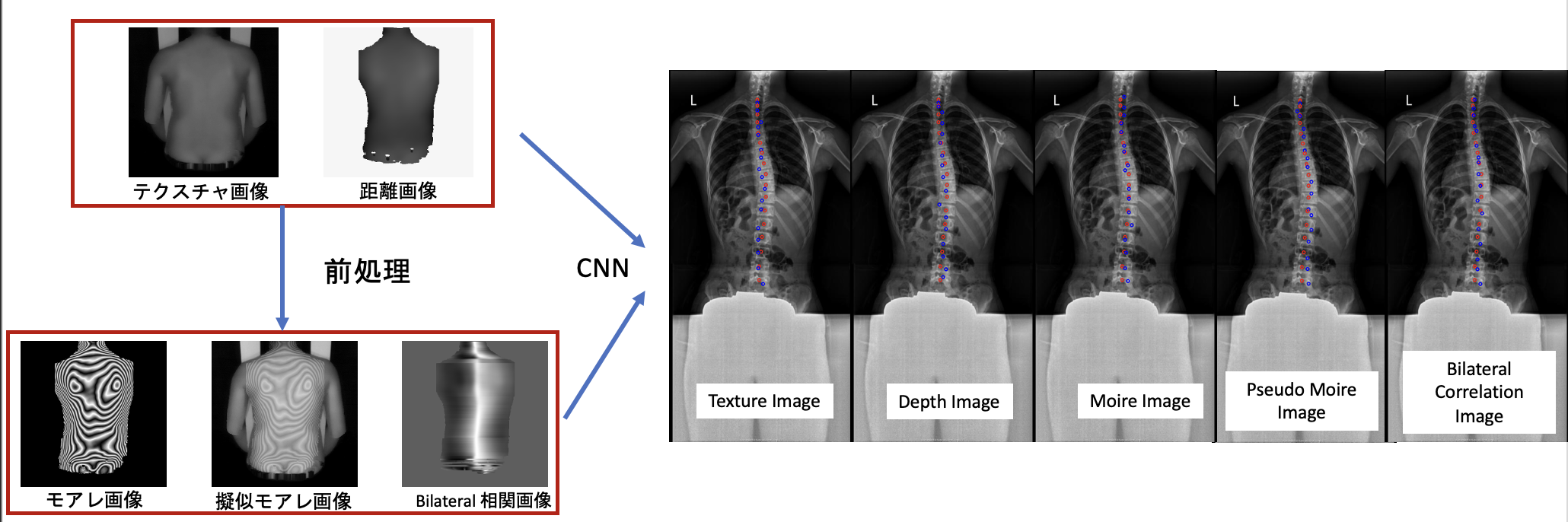

距離画像を使用した側弯症診断

近年、モアレカメラの製造販売が中止になったことにより、モアレ画像からの側弯症診断が難しくなった。本研究では距離画像の前処理でモアレ画像、擬似モアレ画像、bilateral 相関画像を作成することにより、距離画像の特徴を強調させた。 前処理を行った画像で深層学習を用い、脊椎配列を推定した。距離画像からの推定結果より、前処理を行なった画像からの推定結果が精度高いことが確認できた。特に距離画像から復元したモアレ画像の推定結果が精度高い。